Сегодня запустить нейронку у себя на компьютере стало значительно проще, чем в начале их появления. Но это не отменяет требований к большому количеству GPU на устройстве для их корректной работы. Как же узнать, потянет ли твой ПК очередной ChatGPT?

Для решения этой задачи можно воспользоваться сайтом SelfHostLLM, который поможет рассчитать необходимый объём GPU и количество конкурентных запросов к LLM при развёртывании их локально. Поддерживаются Llama, Qwen, DeepSeek, Mistral и многие другие.

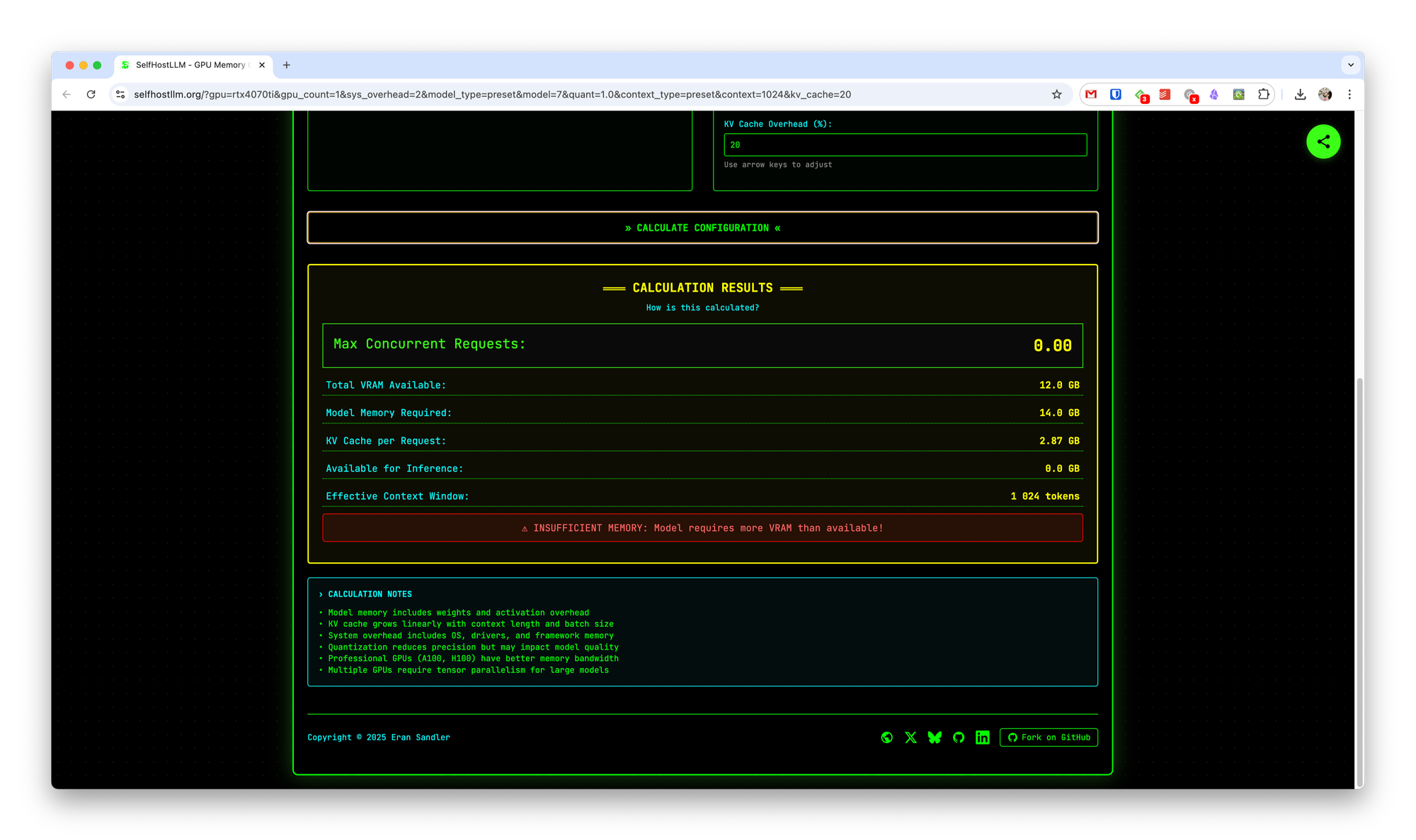

Для этого в левой половине сайта нужно указать ваши текущие параметры GPU, а справа выбрать параметры нужной LLM модели. После чего при нажатии на кнопку Calculate configuration вы получите информацию о том, хватит ли вам этих характеристик.